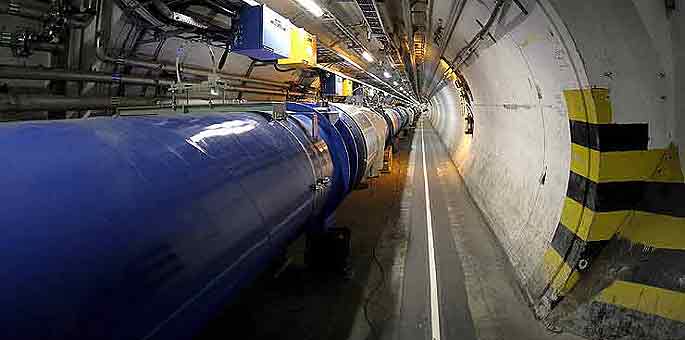

¿Cuál es la estructura última de la materia? Esta pregunta motivadora desde hace al menos 2500 años, aún sigue abierta para la Física de Partículas, y es una de las causas para la construcción del acelerador circular de mas de 8 kilómetros de diámetro. El LHC (Large Hadron Collider; Gran Colisionador de Hadrones) que actualmente esta comenzando a operar, fue construido por la Organización Europea para la Investigación Nuclear (CERN) (1), llevó mas de 12 años y mas de 4.000 millones de dólares.

La pregunta sobre la estructura elemental de la materia tuvo una respuesta fuera de conjeturas, recién hace unos 200 años. El científico inglés Dalton estableció una teoría en que la materia esta formada por partículas que llamó átomos (1803), explicando las causas de varias leyes químicas antes halladas experimentalmente. Marcó así un punto relevante, porque por primera vez en la Historia fue confirmándose que toda la materia conocida tiene carácter discreto (no es continua), y está formada por ’ladrillos’ o unidades microscópicas que se consideraron (en esa época) indivisibles.

Una sola célula biológica por ejemplo, puede contener del orden de 1000 millones de esas partículas ’elementales’, que son lo suficientemente pequeñas para no poder observarse con un microscopio óptico.

Cabe aclarar que en Física se puede definir como ’partícula elemental’ a un objeto indivisible, tal que no es posible distinguir su estructura interna, en el sentido que los errores de medición de todos los sistemas para medir disponibles en ese momento, no lo permiten. La partícula elemental es representada como si fuera un ’punto’ en el espacio, que tiene además asociada determinadas propiedades (como masa, carga eléctrica y otras). De manera que el concepto de ’elemental’ así definido, no es absoluto.

Así el avance científico-tecnológico, hizo que hacia fin de siglo XIX, el átomo dejara de ser partícula elemental, al descubrirse el electrón (experimento de J.J. Thomson, 1897) como una parte integrante del átomo.

A principios del siglo XX se fue terminando de comprender como es la estructura del átomo (Rutherford, 1918), al descubrirse el protón (que se halla concentrado en la parte central o núcleo del átomo), y finalmente en 1932 se detectó el neutrón (Chadwick), que también se halla en el núcleo atómico. De modo que el protón, neutrón y electrón (constituyentes del átomo) fueron las partículas elementales por unas 4 décadas, pero luego como se verá, se encontró que el protón y el neutrón son partículas compuestas y solo el electrón es elemental.

A partir de los años 30’s fueron descubiertas otras partículas subatómicas que parecían no estar en el átomo, como por ejemplo los positrones, neutrinos, los mesones.

Cómo son descubiertas las partículas fundamentales del Universo

Hasta la década de los 50’s buena parte de esas partículas fue descubierta investigando la ’radiación cósmica’, que es un flujo (’lluvia’) natural de partículas (en gran parte protones) algunas de ellas con muy alta energía (incluso superiores al LHC), que llega permanentemente a la Tierra desde el cosmos, y se cree que es originada por estrellas que han explotado. Al entrar en la atmósfera interactúan con los núcleos de sus átomos y dada la elevada energía en juego pueden crearse toda una gama de otras partículas.

Este mecanismo, es como si para encontrar la estructura interna de un objeto que no se puede desarmar, se le dispara otro para ’romperlo’, y de la colisión (y rotura) surge información de su interior, y cuanto mayor es la energía del ’proyectil’ se obtendrá mayor información sobre las partes pequeñas, así para penetrar cada vez mas las estructuras subatómicas serán necesarias energías cada vez mas elevadas. Pero la analogía no va mas allá.

El caso de Física de partículas tiene mucho mayor complejidad, no es solo una fragmentación, ya que en la colisión pueden crearse nuevas partículas que no estaban entre los constituyentes de las originales. Hecho que esta de acuerdo con la teoría de la Relatividad Especial (Einstein, 1905) y su equivalencia entre masa y energía, en que ésta se puede convertir en masa (y viceversa).

Para sistematizar las investigaciones y obtener condiciones controladas de laboratorio, había que reproducir artificialmente un mecanismo similar al de la radiación cósmica. Una de las motivaciones de peso que ayudaron a semejantes emprendimientos fue que después de la Guerra Mundial II, los gobiernos de algunas potencias creían que el poderío militar asegurado por la bomba atómica, estaba íntimamente ligado a la Física Nuclear. De modo que desde la década de 1950 dieron impulso al diseño y construcción de los llamados ’aceleradores de partículas’, destinados al principio para investigar el núcleo atómico.

Estos aparatos producen fuerzas sobre partículas con carga eléctrica (como el electrón o el protón por ejemplo) aplicando campos electromagnéticos. Las partículas aceleradas colisionan con otras y en esa interacción puede surgir nueva información.

El tubo de rayos catódicos (CRT) de los televisores ampliamente utilizados hasta hace pocos años, es un acelerador de partículas. Un filamento caliente emite electrones (que tienen carga eléctrica negativa) que son acelerados por un campo eléctrico (originado por una diferencia de potencial (voltaje)), y finalmente colisionan contra los átomos de la pantalla, generando en este caso luz que es lo que permitirá ver la imagen. La energía que puede alcanzar un electrón en el CRT es del orden de 10 mil electrónvolt (10 KeV; el electrónvolt (eV) es una unidad de energía) (2). Los tubos de rayos X utilizados en medicina para tomar radiografías, son también aceleradores de partículas (electrones) que permiten obtener energías del orden del 100 mil eV (100 KeV). Tanto en los televisores como en los tubos de rayos X, los electrones son ’relativistas’ (esto es, tienen velocidades muy cercanas a la máxima velocidad posible para todo objeto material que es la velocidad de la luz en el vacío, según la teoría de Relatividad Especial).

En los primeros aceleradores para laboratorio construidos por los países industrializados, las partículas cargadas alcanzaban energías del orden de 1 millón de eV (1 MeV). En el acelerador de partículas (protones) mas potente actualmente construido, el LHC, se obtienen energías del orden de 10 millones de millones de eV (10 TeV), es decir 10 millones de veces mayores que en los primeros aceleradores (en realidad, como es un ’colisionador’ de dos haces opuestos de protones relativistas de 7 TeV cada uno, se obtendrán 14 TeV).

Las actuales partículas elementales. El Modelo Estándar

La ’carrera’ de los aceleradores de partículas de los años 50’s, llevó a que se encontrara una variedad sorprendente (cientos) de partículas nuevas. A principios de los 70’s, esos resultados experimentales pudieron ser interrelacionados bajo el formalismo de la Teoría Cuántica de Campos (QFT), que utiliza las dos teorías físicas centrales de principios del siglo XX (la Relatividad Especial y la Cuántica) obteniéndose el llamado ’Modelo Estándar’ de partículas (y fuerzas). Explica un buen número de partículas descubiertas en los aceleradores, y cuando fue planteado en los 70’s predijo teóricamente la existencia de nuevas partículas elementales no encontradas todavía en esa época. Actualmente, todas las partículas que el modelo indica han sido encontradas, salvo un objeto crucial y allí entra en juego el nuevo acelerador LHC.

Este modelo describe a toda la materia conocida (3) como formada por una docena de partículas elementales, 6 se llaman ’quarks’ y las otras ’leptones’, gobernadas por las 4 fuerzas fundamentales que hasta hoy se conocen en la naturaleza, aunque el modelo describe solo 3, ya que en la escala microscópica de las partículas la gravitación es tan débil como para poder en principio despreciarse. Las otras son la fuerza electromagnética, la fuerza débil y la fuerte, estas dos últimas son subatómicas de corto alcance. De modo que el modelo, aunque viene teniendo un excelente consistencia con los resultados experimentales, no es completo para describir la naturaleza.

En cuanto a las fuerzas, la Teoría Cuántica de Campos (QFT) en la cuál se basa el Modelo Estándar, describe las interacciones entre partículas como intercambio de otras partículas llamadas ’mediadoras o intermediarias’ (aunque son partículas virtuales en el sentido de la Mecánica Cuántica). Como ejemplo grosero de este mecanismo se pueden suponer dos patinadores sobre hielo, tal que uno arroja una bolso pesado al otro; tanto el que lo arrojó como el que lo recibió sufrirán un impulso que tiende a alejarlos. Los patinadores harían de ’partículas’, el bolso de ’partícula mediadora’, y el efecto es como si hubiera una fuerza.

Pero por una parte, la matemática del Modelo Estándar para la interacción débil (usa un caso particular de la QFT que se llama teoría cuántica de campos de gauge (medida), y sus simetrías) requiere que sus partículas mediadoras tengan masa nula, aunque por otra parte las evidencias experimentales muestran lo contrario. De modo que el modelo no explica el ’origen de la masa’.

Una ’pieza’ clave: el bosón de Higgs

Entonces, para poder aplicar la teoría de gauge, Peter Higgs, Robert Brout y François Englert conjeturaron que la masa vendría por otro lado. Postularon un mecanismo externo en que la masa provendría del vacío, que no sería tal sino que habría un campo llamado de Higgs, cuyo cuanto (bosón de Higgs) proveería la masa a todas las partículas (burdamente, como trozos de papel absorbente (partículas) impregnándose en un charco de tinta (campo de Higgs)).

El bosón de Higgs todavía no ha sido hallado, y es una de las principales tareas del recientemente activado acelerador europeo LHC. El problema es que el modelo no predice su masa, sino un intervalo en el cuál debería existir (aprox. entre 0,1 TeV y 1 TeV) y que es cubierto por el LHC. De todas maneras si no es hallado, significará también un avance importante ya que los físicos deberán proponer nuevas ideas para explicar el origen de la masa de las partículas.

Resumiendo, actualmente se plantea (según el Modelo Estándar) que toda la materia conocida del Universo esta formada por partículas cuyos constituyentes elementales son los quarks y los leptones, que interactúan por 4 fuerzas.

Los leptones (como el electrón por ejemplo), puede encontrarse como partículas libres, en cambio los quarks siempre están en estados ligados (formando por ejemplo el protón y el neutrón).

Los hadrones con los que trabajará el Gran Colisionador de Hadrones, son partículas compuestas por quarks, antiquarks (su antipartícula) y gluones (partículas mediadoras de la interacción fuerte).

El acelerador LHC permitirá confirmar o descartar el mecanismo propuesto por Higgs (et all) sobre como las partículas adquieren masa, uno de los puntos clave para seguir avanzando en la frontera del conocimiento sobre partículas elementales.

Si se comparan figurativamente tamaños típicos de los quarks y los átomos (cuánticamente las partículas no tienen borde, ni tamaño definido), para el átomo es del orden del Angstrom (1 millonésima parte de 1/10 de milímetro), el protón es unas 100.000 veces menor que el átomo, el electrón (leptón) y el quark son 1000 veces menores que el protón. (Pensando hipotéticamente en una escala macroscópica, si el átomo tuviera un diámetro de 10 kilómetros, el protón tendría 10 centímetros y los electrones y quarks 1/10 milímetros)

Verdades a medias. El LHC como factor estratégico

¿Porque el enorme esfuerzo europeo en la construcción del LHC, el acelerador de partículas actualmente mas potente del mundo?

Luego del colapso de la URSS, y tal vez suponiendo que ya no era tan necesario mostrar el liderazgo en ciencia básica, el Congreso de EEUU canceló (1993) la construcción del acelerador de partículas Super Colisionador Superconductor (Superconducting Super Collider; SSC), mayor que el europeo LHC. El acelerador cuyo proyecto comenzó con Ronald Reagan y fue continuado por George H. W. Bush se había empezado a construir en Texas, era circular con un diámetro de casi 28 kilómetros y tendría una energía de 40 TeV. Posiblemente su cancelación haya sido un grave error estratégico, Clinton había intentado detenerla.

Se suele afirmar, que el LHC producirá avances fundamentales en la investigación básica de Física de Partículas, y aquella parte del conocimiento científico producido que se constituya como bien público enriquecerá a la Humanidad en el corto plazo, y en el largo plazo contribuirá con las necesidades sociales, sentando bases para la prosperidad e innovación. Sin embargo, las consecuencias y motivos para semejante emprendimiento en investigación básica trascienden esta visión idealizada.

En los hechos los resultados de los experimentos con el LHC, no solo producirán avances en la investigación teórica, sino que con cierto retardo también lo harán en la investigación aplicada, estos a su vez en algún momento se irán transmitiendo a las cadenas de producción con su escala de valores de competitividad y mercado. En la concepción capitalista, la ciencia intenta dominar la naturaleza en beneficio del sistema de producción, y en su escala de valores primero está el Capital y después los hombres y el medio ambiente. En el desarrollo de este proceso, los conocimientos derivados serán indefectiblemente explotados hasta sus últimas consecuencias. Es decir, que no producirán únicamente beneficios para la Humanidad, ya que al incorporar la concepción mercantilista no se reparará en los aspectos nefastos, y hasta extremo negativos para la sociedades como la industria bélica. Es cierto que no se puede predecir cuantitativamente el nivel de impacto positivo ni negativo, aunque éste último puede ser en principio igualmente probable que el primero, por mas que las partes interesadas generalmente invoquen públicamente solo ’el progreso, la prosperidad y la innovación’.

Estratégicamente el acceso a la frontera del conocimiento en la estructura de la materia, contribuirá significativamente a afianzar la supremacía y liderazgo científico mundial para las potencias regionales europeas. Y hace a la directiva que vienen aplicando en el mundo tanto éstas como EEUU: ’evitar que emerja un rival’, que en lo no militar incluye prevenirse de la sorpresa tecnológica de las potencias competidoras y a su vez creársela; controlar y acotar el desarrollo científico-técnico de las naciones en desarrollo y con débil industrialización. Para lo cual utilizan diversos mecanismos, frecuentemente mediante el mismo conocimiento. Paradójicamente algunos convenios de cooperación pueden influenciar sobre la elección de campos de investigación que siguen a ’remolque’ de las potencias dominantes, y sobre ’modas’ centrales que debiliten la creación propia o endógena de conocimiento científico.

El proyecto, diseño, construcción y posterior operación e investigaciones de una máquina tal, genera importante actividad y es fuente de ocupación, desde obreros de la construcción, hasta administrativos, profesionales, técnicos, científicos e industrias proveedoras pero principalmente de los países centrales. Los primeros avances científicos, beneficios económicos y aplicaciones militares generados por el emprendimiento serán capitalizados por las potencias industrializadas involucradas. Es decir en el largo plazo, tendrán una probabilidad relevante de ’amortización’ (aunque no en la forma directa convencional) y alto retorno de inversión en beneficio de la economía de los países centrales constructores. Seguramente así lo entienden algunos inversores, como el Banco Europeo de Inversiones (EIB) brazo financiero de la Unión Europea, que en el 2003 otorgó un crédito de 300 millones de euros para la construcción del LHC.

Actualmente ya se está trabajando en otro multimillonario proyecto europeo, para construir el Colisionador Lineal Internacional (International Linear Collider (ILC)) que opera con principios similares al LHC. Pero así como éste esta diseñado para ’descubrir’ y abrir nuevas áreas de la Física, el ILC será diseñado para explorar detalladamente los descubrimientos que haga el LHC.